WU怨WU悔

数据采集工程师助理

- 公司信息:

- 景顺科技网络

- 工作经验:

- 3年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 下班后

- 所在区域:

- 其他

- 全区

技术能力

1、基本的编码基础(python)

对于任何编程工作来说都是必须的。数据名字和值得对应(字典),对一些url进行处理(列表)等等。掌握牢固。熟悉python编程语言,熟悉相关的框架和库。我主要用Python写爬虫。

2、任务队列。

当爬虫任务很大的时候,写一个程序跑下来是不合适的:

所以我们需要一种任务队列,它的作用是:讲计划抓取的网页都放到任务队列里面去。然后从队列中拿出来一个一个执行,如果一个失败,记录一下,然后执行下一个。这样就可以一个接一个地执行下去。也增加了扩展性,几亿个任务放在队列里也没问题,有需要可以增加worker,就像多一双亏筷子吃饭一样。

3、数据库

数据保存肯定要会数据库的。不过有时候一些小数据也可以保存成json等。我有时想抓一些图片就直接按照文件夹保存文件。推荐使用NoSQL的数据库,比如mongodb,因为爬虫抓到的数据一般是都字段-值得对应,有些字段有的网站有有的网站没有,mongo在这方面比较灵活,况且爬虫爬到的数据关系非常非常弱,很少会用到表与表的关系。

4、HTTP知识

HTTP知识是必备技能。因为要爬的是网页,所以必须要了解网页。首先html文档的解析方法要懂,比如子节点父节点,属性这些。我们看到的网页是五彩斑斓的,只不过是被浏览器处理了而已,原始的网页是由很多标签组成的。处理最好使用html的解析器,如果自己用正则匹配的话坑会很多。

5、运维

实际工作中运维和开发的时间差不多甚至更多一些。维护已经在工作的爬虫是一个繁重的工作。随着工作时间增加,一般我们都会学着让写出来的爬虫更好维护一些。

项目经验

爬百度贴吧的评论

爬京东的商品名和价格包括图片评论,保存到excel

爬取豆瓣电影的评分,详细介绍报保存成文件

爬取斗图网的图片保存文件

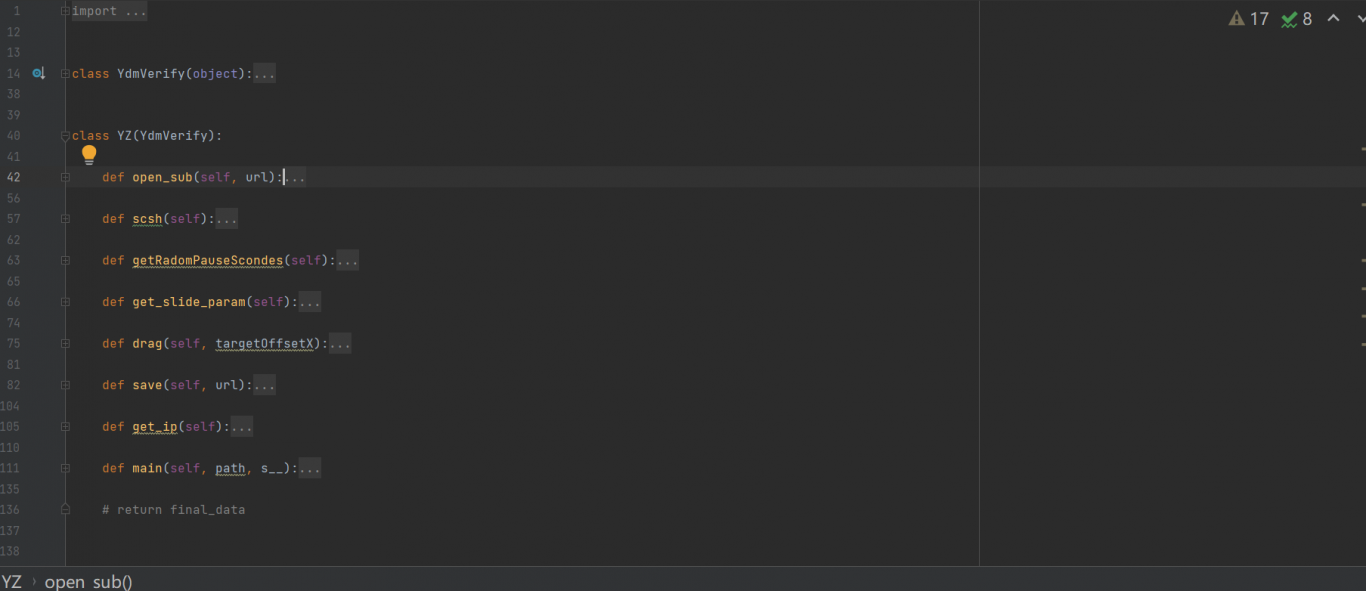

案例展示

-

通过验证码

在进行某网站的数据采集时遇到了验证码的保护措施,为了达到能够批量将数据采集下来的目的,需要接入第三方平台。 采用python的selenium可轻松解决验证码的反爬。

-

通过验证码

在进行对网站数据的批量采集时遇到了验证码的反爬措施,对于这一问题有两个解决方案, 较简单的是采用selenium实现验证码的破解。

相似人才推荐

-

1500元/天高级计算机视觉工程师爱思维三维测量概要:三维重建 slam bundle adjustment c++,python, matlab, c

-

1000元/天高级协议工程师移远通信概要:1,熟悉无线通信协议包括3GPP协议; 2,熟悉全球各个运营商认证的需求和测试用例规范; 3,熟

-

1000元/天研发经理广州南翼软件有限公司概要:.net framework C# C++/CLI java/android 数据库:sqls

-

1000元/天研究员卡耐基梅隆大学概要:精通各种编程语言设计与实现 精通以下语言: OCaml, Haskell, SML, Pyt

-

1000元/天开发工程师成都英孚泰克概要:游戏开发软件 unity 3dmaxs 开发工具 vs 语言C# 技术wpf asp.

1000元/天开发工程师成都英孚泰克概要:游戏开发软件 unity 3dmaxs 开发工具 vs 语言C# 技术wpf asp. -

1500元/天高级架构师北京泛生子基因科技有限公司概要:1、熟悉分布式系统架构设计及相关技术(缓存Redis、MongoDB,消息队列RabbitMQ,分布

1500元/天高级架构师北京泛生子基因科技有限公司概要:1、熟悉分布式系统架构设计及相关技术(缓存Redis、MongoDB,消息队列RabbitMQ,分布 -

1000元/天研发阿里巴巴概要:请填写您所从事的顾问角色所具备的技术能力。不少于100字,建议200字以上,将获得优先展示。您已在“

-

500元/天安全服务工程师北京梆梆安全概要:红队外网打点、WEB渗透测试、APP渗透测试红 有三年安全行业工作经验,有在监管侧技术支撑经验同时