行者

大数据开发工程师

- 公司信息:

- 中信银行

- 工作经验:

- 5年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 可工作日远程

- 所在区域:

- 深圳

- 福田

技术能力

* 熟悉 Hadoop 生态集群以及其相关技术、对 Hive,HBase,Spark 有深入理解。

* 熟练使用 Hive ,Clickhouse语言,可以熟练写 HiveSql 和 SparkSql(Scala),并能够数据优化。

* 熟悉 Hive 和 Spark 的参数调优,对集群的维护有一定的经验。

* 熟悉 Sqoop,Datax, Kettle,Azkaban,DolphinScheduler 等数据迁移收集和调度工具的使用。

* 熟悉 Hadoop 集群的安装部署,对集群内各种组件内存资源分配调度有一定经验,熟悉Kerberos 安全认证,了解 k8s 和 Docker 的使用,了解 ELK 的使用。

* 掌握 Java,Scala 语言,参与过编写复杂场景的 udf 和 udtf 函数,了解多线程的使用。

* 掌握 Canal 的使用,了解 Maxwell 和 FlinkCDC 等流式工具的使用。

* 熟悉 Presto,Impala,Kylin,ClickHouse 等 OLAP 数据库的使用。

* 熟悉存 Shell 脚本 MySQL等主流数据库和 FineReport 报表工具。

项目经验

项目名称:Sass 数智营销引擎 2022.03—2023-01

开发环境: Idea,Java,Hive,Spark,Clickhouse,Impala,Presto,HBase,Flink

项目简介: 项目主要针对中型型企业客户,项目基于 ds 源码重新改造开发,能够使用不同的数据引

擎处理数据,支持离线和流式处理支持周期和手动加工数据,支持 OLAP 引擎,

Clickhouse,Impala 等,支持离线 Hive 和 Spark 批处理,。支持不同类型数据源数据处理,支持不

同文件上传处理字段解析,主要功能点,支持可视化模型建设,支持不同类型数据集抽取,支持高级数

据分析,漏斗分析,归因分析,用户路径分析等。

项目职责:

1. 可视化建模功能点开发。

2. 高级数据分析功能点开发。

3. 动态 clickhouse sql 底层代码拼接。

4. Hive,Mysql,Clickhouse 等自定义 sql 解析校验。

项目名称:垃圾回收分类 2021.03—2022.03

开发环境

Spark,Hive,HBase,Hadoop,Mysql,Mongodb,Flink,Java,Datax,Presto,Impala,FineReport

项目简介:通过在全国投放垃圾设备,用户通过扫码形式或者办理卡片分类投放垃圾,后端数据主要

分为业务数据和行为数据,使用开源大数据 hadoop 集群处理数据,使用 Azkaban 调度任务和

Datax 进行数据迁移,使用 Flink 实时同步数据到 HBase,使用 FineBI 和 CBoard 展示数据。

项目建设:采用维度建模并且分层同步数据,主要分为 ods,dwd,dws,dim 和临时数据层,项目中

分指标体系进行建设,业务上围绕宣传->投放->收集->运输->转运->入库->套现等环节进行分析

建立指标树,指标模型建设方法使用海盗模型,按照 拉新->活跃->留存->变现->推荐等环节分析

,指标分为一级指标次要指标和三级指标,按时间,地域,渠道等维度拆分,层层递进,便于定位

问题。

项目职责:

5. 数据实时同步和离线同步的代码开发。

6. 使用 Canal 监听 mysqlbinlog 日志同步至 Kafka,经 Flume 转存至 Hdfs

7. 负责 etl 开发和人物画像和各种指标的开发。

8. 编写复杂业务场景的 UDF 和 UDTF。

9. 数据质量规则的校验。

10.解决开发中出现的问题,并对集群进行维护。

11.对数据词典进行维护和文档的输出。

项目名称:金融数据报送 2020.09—2021.02

开发环境:Hive,Spark,Hadoop,Java,shell,DB2,Kafka,Flink,Kylin,Impala,Presto

项目简介:数据报送分为总行报送和监管报送,报送频度包括日报送,月报送和季度报送,结果数

据会经过 4 项校验,保证每天能够准确报送数据发给总行。

项目架构:

模型采用星型模型建模,表包括实体表,维度表,事务性事实表和周期性事实表,同步策略包括

全量,增量,拉链存储,此项目分为 2 条路线,开发路线和测试路线,项目流程为数据加工,数据

预校验,质量规则校验,交叉比对,db2 数据校验,数据核对,数据报送。校验主要针对开发路线

和测试路线进行校验。 数据加工是通过在 workflow 上布置任务,每天进行调度。

项目职责:

1. 负责总行和监管开发路线报表数据的开发。

2. 通过 shell 脚本使用 db2 数据库进行数据校验。

3. 负责质量规则的配置。

4. 使用客户的 ETL 数据抽取入仓。

5. 开发文档的整理输出。

项目名称:XTAG 数据标签系统 2019.07-2020.09

开发环境:Spark,Hive,HBase,Hadoop,Java,shell,Kafka,SparkStreaming,Java,Presto ,Kettle

3

项目背景:近年来数据爆炸式增长,客户的数据趋向于存储于由廉价机器组成的大数据集群环境中,

本标签系统为满足客户的需要,通过在页面上点击选择支持不同的计算(添加字段),支持多种数

据源,Hdfs,Ftp,Hive 数据仓库等,致力于构建具有大数据能力的计算产品,提供从集成人员使用

到终端用户使用的类 BI 工具后台。

项目简介:

通过打开标签系统的页面,建立并选择数据包,数据包下对应 Hive 中 bds 原始表,点击数据

包下的某张表后,选择 HBase 联合主键后可进行数据同步,同步到 Hiv

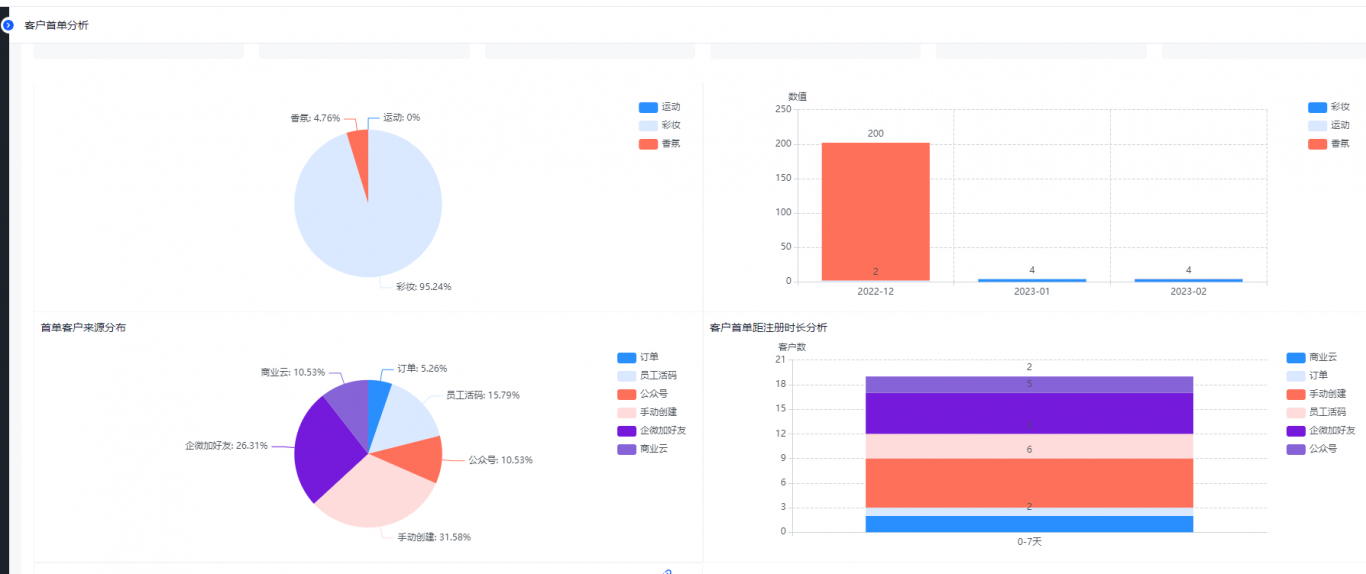

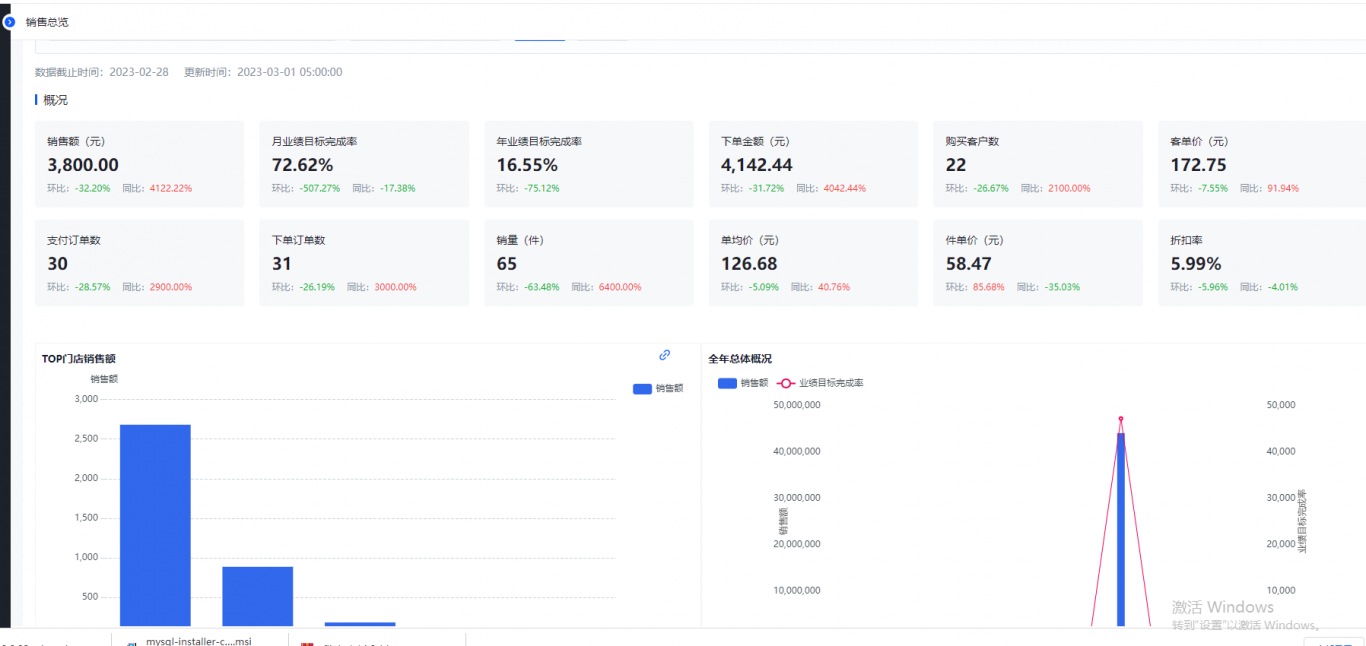

案例展示

-

零售BI统计报表

项目提供供业务人员查看的统计零售 BI 报表,主要分为销售统计,客户统计,商品统计 3 大类型报表,分析模型主要分为漏斗模型,RFM 分析模型等,以智能可视化平台展示统计报表。数 据来源于关系型数据库,以 Clickhouse 列式存储数据库构建离线零售数仓,数据分层 bdm

-

SAAS数智引擎

项目主要针对中小型企业客户,项目基于 ds 源码重新改造开发,能够使用不同的数据引擎 处理数据,支持离线和流式处理支持周期和手动加工数据,支持 OLAP 引擎,Clickhouse,Impala 等,支持离线 Hive 和 Spark 批处理,。支持不同类型数据源数据处理,支

-

零售BI统计报表

项目简介: 项目提供供业务人员查看的统计零售 BI 报表,主要分为销售统计,客户统计,商品统计 3 大类型报表,分析模型主要分为漏斗模型,RFM 分析模型等,以智能可视化平台展示统计报表。数 据来源于关系型数据库,以 Clickhouse 列式存储数据库构建离线零售数仓,数据

相似人才推荐

-

800元/天资深研发工程师美团概要:精通 Java 基础 , 熟练掌握多线程编程,掌握 JVM 原理。熟练掌握 Spring、Spri

-

800元/天高级开发工程师深圳学达科技有限公司概要:1、精通物联网软硬件集成方案的设计与优化,做过无人售货机的平台开发与设计; 2、精通RFID相关的

-

500元/天测试开发工程师字节跳动概要:熟练掌握python、golang、js语言,熟悉mysql、redis数据库,会使用gin、dja

-

500元/天后端开发组负责人安科瑞电气概要:我是猿急送的夏目,一名Java开发工程师 我毕业于扬州大学,现在是某上市公司的软件开发后端团队负责人

-

2000元/天无无概要:熟练掌握python,php后端开发,能够自主完成中小型项目,同时具备较强的渗透测试经验,熟悉各种漏

-

500元/天odoo开发上海开源制造概要:odoo开发经验5年了, 熟练掌握python的语法。 熟练掌握odoo的源码和二次开发, 熟

-

800元/天高级爬虫工程师/全栈工程师长沙营智信息科技有限公司概要:C# MVC Winform/WPF Nodejs Python C++(基础封装) 后端、协

-

800元/天web项目架构师emart概要:熟练掌握sql和mysql数据库操作,能够对sql查询、存储过程进行优化与迭代;熟练掌握python