甜崽小洋

大数据开发工程师

- 公司信息:

- 联想

- 工作经验:

- 5年

- 兼职日薪:

- 800元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 所在区域:

- 其他

- 全区

技术能力

1. 精通 Java ,掌握Python编程语言、熟练使用Scala编程语言

2. 熟练使用 Linux 操作系统, Shell 编程。熟练Maven 、gradle构建工具

3. 理解 Hadoop 的分布式文件系统,掌握mapreduce 原理及实现编程

4. 熟悉 Hive 的工作原理、udf编写、HQL优化及数据仓库建立,能完成对数据的抽取和多维度分析

5. 精通Flink 计算引擎及其使用,如:旁路输出、数据抽取与装载、自定义connector等

6. 掌握 Zookeeper 协调服务工作原理及使用场景

7. 理解 Hbase 的存储原理,Hbase 存储架构,实现数据的毫秒检索

8. 掌握 Spark 任务的执行流程,Spark内存管理,深入理解 Spark 工作机制

9. 掌握 Storm 任务的执行流程及其原理

10. 掌握 Flume、kafka 数据采集工具的原理,实现流式数据的过滤和分析

11. 掌握 NIFI 数据分发系统及其使用

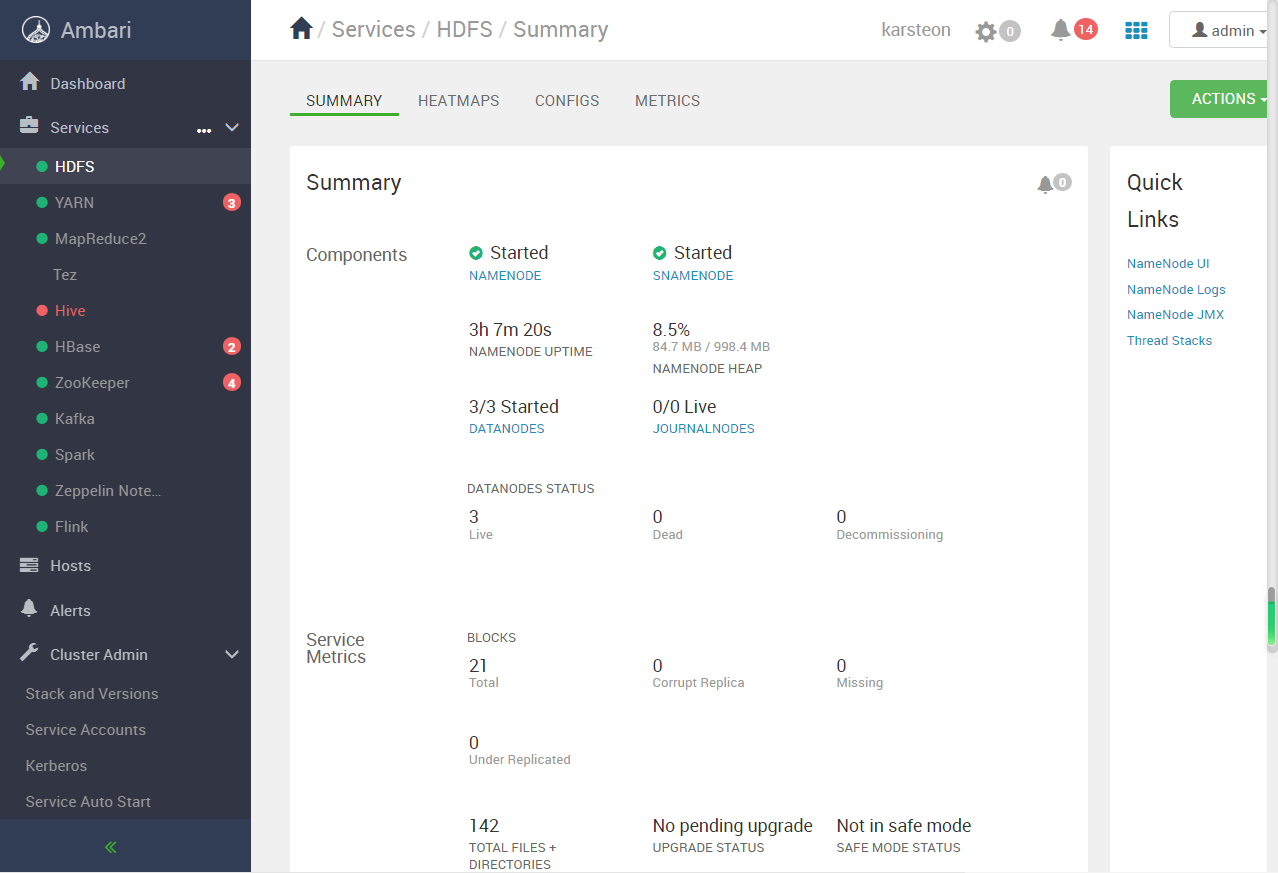

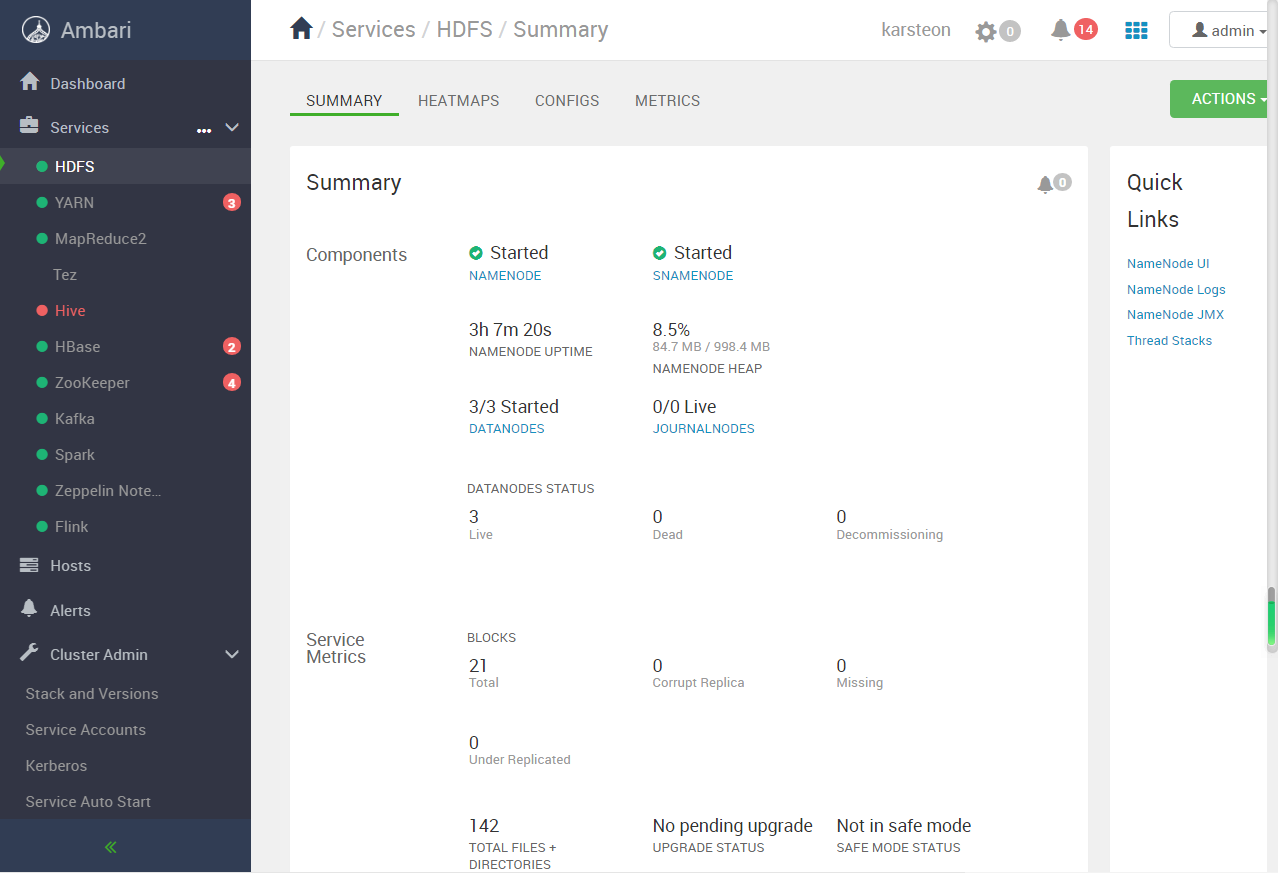

12. 掌握使用 Ambari 集成 Hadoop、Spark、ELK、Jupyter、Infra 等组件

13. 熟练使用 Sqoop 工具,实现非关系型数据库与关系型数据库数据的集成

14. 熟悉使用 Azkaban 工作流调度

15. 掌握 Redis 内存数据库的基本原理及各数据类型的使用,实现数据的毫秒查询

16. 掌握使用 Python 爬虫,Scrapy 框架爬虫、分布式爬虫

17. 熟悉 Oracle、Mysql 数据库,能够进行SQL 开发,并且了解数据库的优化

18. 熟悉 Elasticsearch,Logstash,Kibana

19. 掌握微服务架构开发

20. 熟练使用JPA和Mybatis 持久化框架

21. 熟悉Minio 对象存储服务

22. 熟悉Hudi+presto/Starrocks vs iceberg+presto/Starrocks

23. 了解分布式数据库(ClickHouse、TIDB、Greeplum、OceanBase)

24. 了解机器学习(KNN,Kmeans,朴素贝叶斯,协同过滤,决策树,逻辑回归)

25. 了解 Mahout,MLlib 机器学习库

26. 能阅读英文技术文档。具备良好的文档写作能力

项目经验

项目一:政法委智慧监督平台

项目名称: zfw项目-政法智慧监督平台

开发环境: IDEA+maven+jdk

系统架构: SpringBoot+Flink+Hadoop+Zookeeper+Azkaban+Minio+FTP+Hive+…

项目描述:

Zfw智慧监督平台以数据信息资源的整合管理为重点,全面汇聚政法机关的业务入口数据、跨部门大数

据办案平台案件数据、政法机关内部监督系统结果数据、云上贵州政务共享数据、金融机构数据,实现从数

据采集、处理、分析、服务到应用的全流程贯通,形成全省覆盖、技术领先、服务一流的大数据支撑体系,

有效推进基于大数据的司法权力运行监督管理力的提升。以数据为抓手,以技术手段为依托,实现覆盖政法

机关全域业务的宏观性执法监督应用和专项核查,并建立面向重大事项的督察督办机制。

责任描述 :

1. 参与技术选型与评审;

2. 负责数据分级分类管理的设计以及数据共享;

3. 负责数据概览(数据分布)的设计与开发;

4. 支持Minio作为新数据源,同时选择作为内置的OSS服务;

5. 数据共享支持结构化数据、非结构化数据、数仓以及数据权限 。

6. 负责数仓即时查询开发、支持分区存储与管理功能;

7. 负责数仓资产统计设计与开发;

8. 负责数据备份与还原模块开发;

9. 负责数据库设计文档编写。

开发步骤:

1. 设计数据分级分类管理:

1)等级划分,公开、内部、涉密数据

2)共享规则:公开、无条件共享、有条件共享、不予共享

3)支持权限设置表字段级,文件级

4)支持数据分类

5)支持数据共享,开发api

2. 支持数据分布:

6)数据源、数仓支持数据分布查看功能

7)选择表后点击生成数据概览,后台计算后查看数据分布以及更新

3. 开发Minio作为新数据源,支持Minio作为内置的OSS;

4. 数据共享支持结构化数据、非结构化数据、数仓以及数据权限 ;

5. 开发支持数仓即时查询(毫秒级)以及分区存储与管理功能

1)基于Openlookeng开发即时查询、数据导入导出功能

2)支持分区存储与管理功能

6. 开发部门下数据仓库的资产进行统计和分析:

1) 总览部分(表、元数据、数据量以及空间)、数据趋势、分布、表占用空间等信息

2) 各个数据源贡献信息

7. 开发数据备份与还原,涉及备份任务管理、备份文件管理、还原任务历史等子模块。

项目二:大禹数据中台

项目名称: 大禹数据中台

开发环境: IDEA+maven+jdk

系统架构: SpringBoot+Flink+Hadoop+Zookeeper+Azkaban+Minio+FTP+Hive+…

项目描述:

大禹数据中台是面向PB级数据的一站式数据集成、治理、共享、分析及可视化平台。帮助用户整合多元

异构数据资产,实现统一的数据标准,严格的质量管理,清晰的数据血缘关系,简易快速的数据建模,交互

性的数据展示。通过帮助客户分析海量数据,获得深层次的业务洞察,做出有效决策,实现运行效率和竞争

优势的提升。

责任描述 :

1. 参与技术选型与评审;

2. 负责Flink 1.12的升级;

3. 负责数据生成组件开发;

4. 负责中台数据源安全认证(Kerberos);

5. 负责Hive增量抽取以及流式装载;

6. 负责数据集成新增清洗组件调研与开发;

7. 负责新增数据源开发并同步其他模块 ;

8. 负责多种数据源快速建表设计与开发。

开发步骤:

1. 负责中台Flink 1.12的升级:

1)升级计算引擎,Flink 1.8 升级到Flink 1.12

2)重构flink-common包,多数据源自定义connector

3)SQL查询器升级,重新开发SQL查询解析器

2. 数据集成开发数据生成组件,按相关性开发相关功能:

1)人属性、网络、日期、数字、其它以及规则(包括数字与字符、枚举、正则等规则)

2)支持批量生成和流式生成

3)自定义connector实现

3. 开发中台数据源安全认证,涉及Kerberos认证和Basic认证:

1)支持Hdfs、Hbase、Kafka、Hive启用Kerberos认证

2)支持样例回传以及脏数据启用kerberos

3)数据源管理-支持Kerberos文件管理

4)重新编译Azkaban,增加支持Kerberos任务状态回传

5)ES 添加支持Basic认证

4. 支 持 H i v e 增 量 抽 取 和 流 式 装 载 :

1)开发新增Hive 按时间增量抽取数据

2)自定义Hive connector,增加支持Hive流式装载

5. 开发数据集成新

案例展示

-

大数据平台组件集成

大数据平台 项目名称: 大数据平台 开发环境: IDEA+maven+jdk 系统架构: SpringBoot+Flink+Hadoop+Zookeeper+Azkaban+Minio+FTP+Hive+… 项目描述: 大数据平台是面向PB级数据的一站式数据集成、治理、

-

神经网络-图像分类

卷积神经网络(Convolutional Neural Network,CNN)在图像分类任务中取得了巨大的成功。数据准备:首先,需要准备一个包含标记好的图像样本的数据集。数据集应包括训练集和测试集,其中训练集用于模型的训练和参数优化,测试集用于评估模型的性能。 模型构建:

-

大数据平台组件集成ambari 二次开发

Ambari是一个用于Apache Hadoop集群管理和监控的开源工具。如果您想进行Ambari的二次开发,以下是一些常见的操作和扩展点: 插件开发:Ambari支持插件机制,允许您通过编写自定义插件来扩展其功能。您可以开发自定义插件来添加新的服务、配置、指标和操作等。

相似人才推荐

-

1000元/天研发工程师阿里巴巴概要:熟练掌握java语言,编码过程中追求代方法内聚性,接口扩展性,有良好的建模和抽象能力。 对mysq

-

800元/天无无概要:在读研究生、软件工程专业本科毕业生,熟练掌握编程语言C++、Java、Python语言。 自然语言

-

500元/天全栈工程师中关村概要:1.python后端开发, 2.各类网站爬虫开发。 3.前端vue开发。 4.自动化脚本编写。

-

1000元/天资深研发工程师百度公司概要:1、编程语言方面:精通python、c++、javascript。熟悉java、c#、html。

1000元/天资深研发工程师百度公司概要:1、编程语言方面:精通python、c++、javascript。熟悉java、c#、html。 -

600元/天算法工程师tcl概要:精通图片处理,图片识别算法开发,熟练机器学习,医学图像处理,SLAM框架调用与优化 工作技能:C+

-

500元/天高级爬虫工程师摄星智能概要:我是一名技术爱好者,熟练掌握微信小程序开发、Python爬虫(包括逆向)、Django后端开发和Un

-

1000元/天软件工程师中邮信息科技概要:1、Java 基础扎实,理解并能使用 Java 多线程及线程池,集合框架,IO 类库等,良好的编程习

-

500元/天引擎开发工程师沙盒网络概要:本人从事过java开发,引擎C++/lua开发,以及Python爬虫,目前在给一家公司做Python