倒数NO.1

爬虫工程师

- 公司信息:

- sao

- 工作经验:

- 3年

- 兼职日薪:

- 500元/8小时

- 兼职时间:

- 下班后

- 周六

- 周日

- 可工作日驻场(离职原因)

- 可工作日驻场(自由职业原因)

- 所在区域:

- 重庆

- 全区

技术能力

1、熟练举握requests,scrapy,scrapy·redis模块发送请求,获取响应后处理网页数据,熟练构建分布式爬

虫,Linux下的定时启动爬虫

2、熟练使用正则表达式xpath、Selenium、提取网页元素

3,熟练使用requests和scrapy。selenium的模拟登录

4、熟练对各种加密算法进行破解

熟练使用mysqlredis、MongoDB的增删改查

项目经验

拉勾网:

爬取拉勾网一二线城市U1设计,前端、php、python、Java、数据分析、人工智能等公司的名称、地址、网址、规模、招聘需求、新资状况等

遇到问题及解决方案如下:

1、分析目标网站真实request地址和response内容,使用代理试水网站反爬中圾别,检测是否有投毒数据.

2、使用Selenium+PhantomJS模拟登陆获取cookie信是,携带cookie访向网页内器,采用隧道动态io代理和随机USER-AGENT反反爬

3、爬取量量较大,用scrapy-redis爬取,因为该框架实现url和数据去重、持久化,通过MD5加密,实现网页数

据的去重和更新,构建增量式爬中程序

4、数据保存在json字符串中,转化成python字典,提取数据

5、保存数据到MongoDB和CSV

6。使用logging模块编号监控程序进行爬中监控,并根据日期定向输出日志到log文件

瓜子二手车:

1、瓜子二手车有反爬,需携市cookie进行访问

2、requests底层没有封装ur去重的方法,手动实现利用redis集合构造url去重(注:如果公司没有redis可以利用python集台set,保存请求的url,再读取set中的内容马入本地文件,后面每次运行摩的时候,再将本地文件中的url读取到set集合中,可以实现简易的url去重》

3、选择md5加密,尽可能少的占用redis内存

4、请求中加延时,考虑网站能否打开和打开时间问题,一般需要加异常判断、超时。retny等减少报错

5、增量式爬虫,将数据保存到数据库,对重复的字段对应的数据更新操作

6、构建USER-AGENT池,使用随机代理,随机IP莱用阿布云动态IP

7、使用logging模块编写监控程序进行爬虫监控,并根据日期定向输出日志到log文件

腾讯招聘,阿里招聘、百度招聘:

1、爬取量蚊大。用scrapy-redis爬取,因为该框架实现ur和数据去重、持久化、分布式比效方便

2、采用隧道动态ip进行采集数据

3、需要抓包并查找到对应的response,

4、数据保存在json字符串中,转化成python字典,提取数据

5、分别保存数据到MongoDB和Mysql

6、使用logging模块编写监控程序进行爬虫监控,并根据日期定向输出日志到log文件

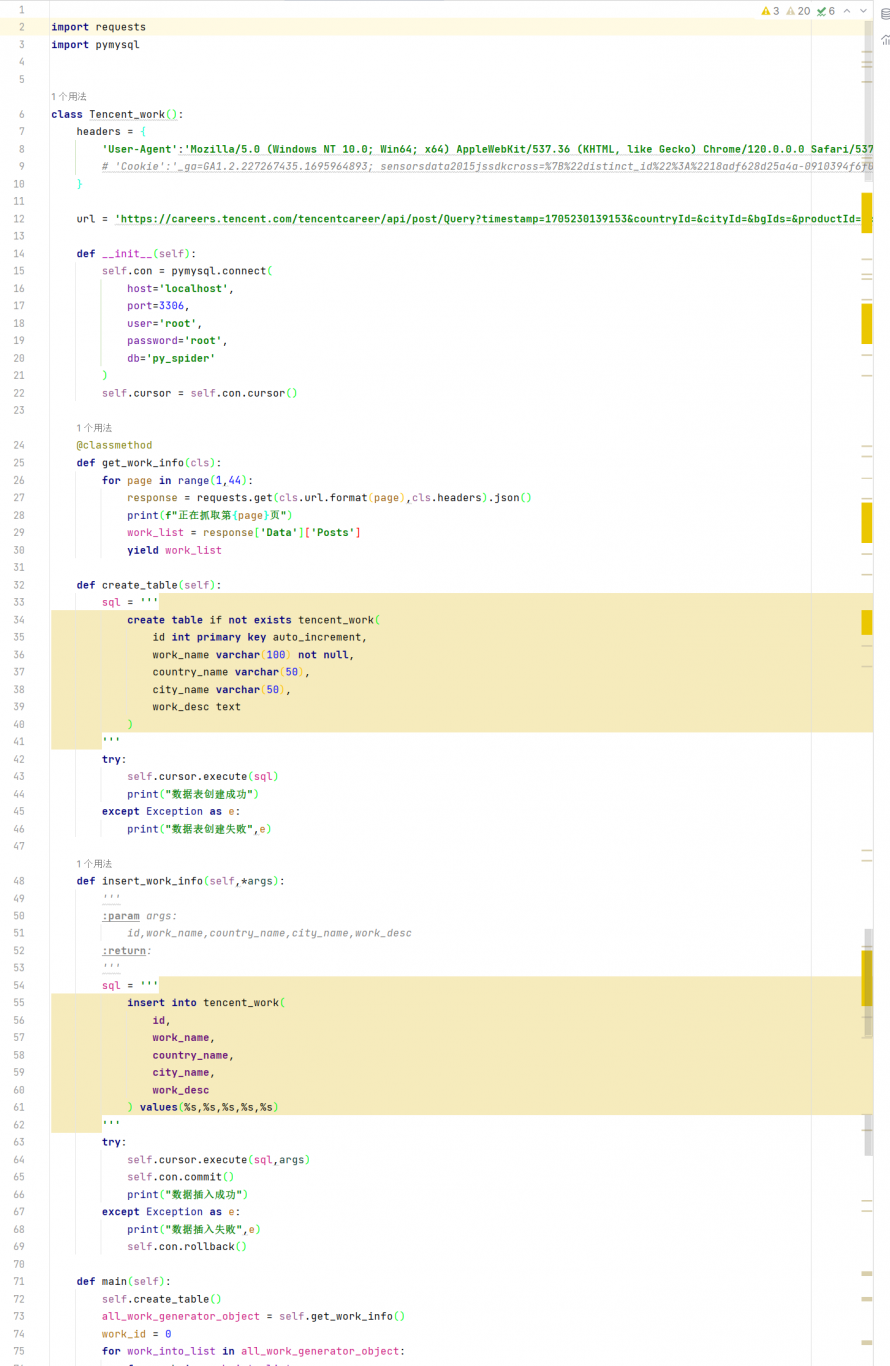

案例展示

-

腾讯招聘、芒果DV抓取

1、爬取量蚊大。用scrapy-redis爬取,因为该框架实现ur和数据去重、持久化、分布式比效方便 2、采用随道动态ip进行采集数据 3、需要抓包并音找到对应的response, 4、数据保存在json字符串中,转化成python字典,提取数据 5、保存数据到mysql

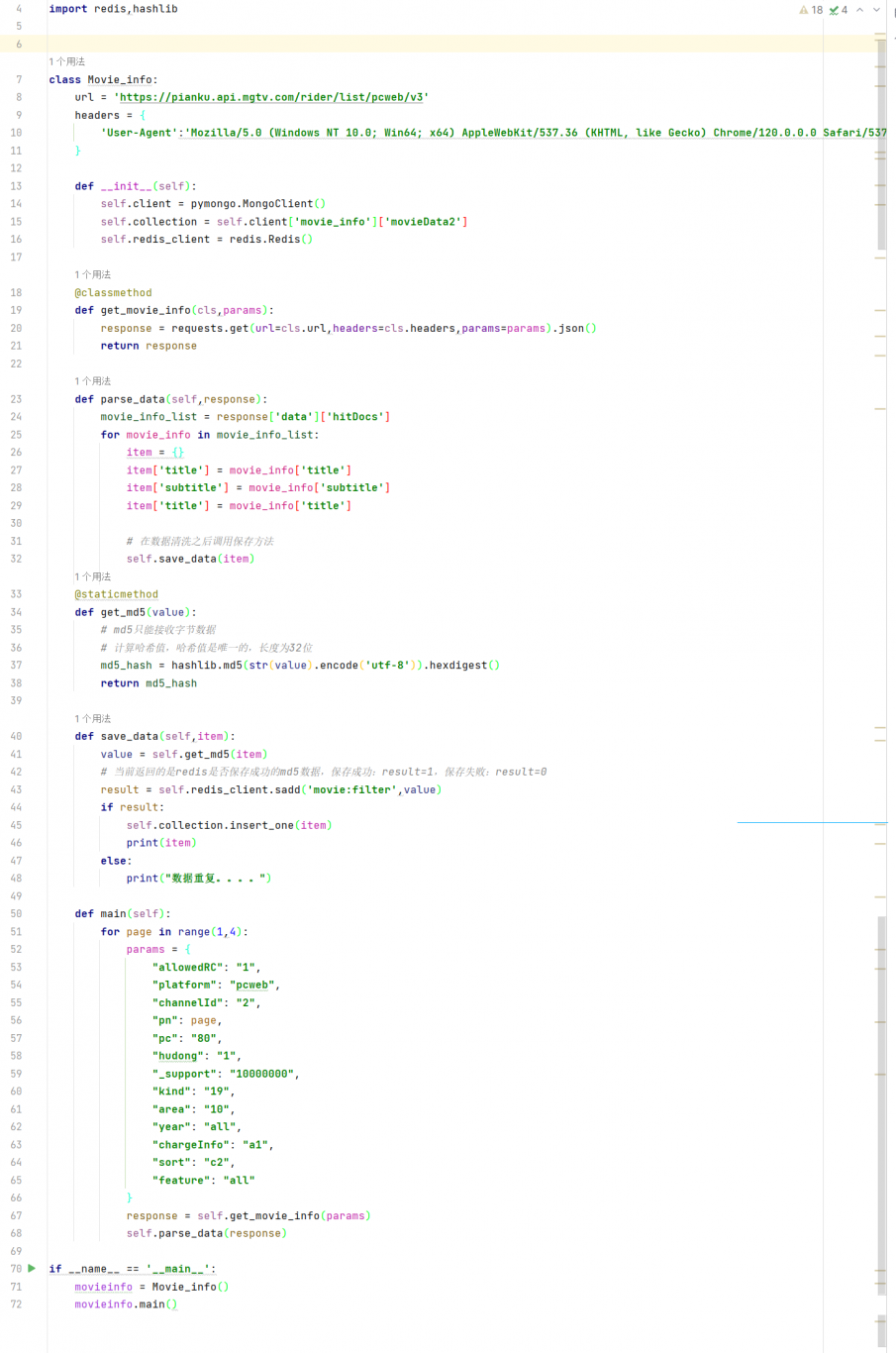

-

芒果DV抓取

1、爬取量蚊大。用scrapy-redis爬取,因为该框架实现ur和数据去重、持久化、分布式比效方便 2、采用随道动态ip进行采集数据 3、需要抓包并音找到对应的response, 4、数据保存在json字符串中,转化成python字典,提取数据 5、保存数据到Mongo

相似人才推荐

-

500元/天高级前端开发工程师360概要:熟悉 Vue3、Vite、ELement-PLus,能够快速学习适应前端新技术 熟悉Node.js

-

500元/天web前端工程师北京阳狮文化有限公司概要:熟练运用 vue2 以及使用 vue3,React Hooks 熟练 H5,C3 等相关技术,

-

500元/天gis前端工程师长沙海图科技有限公司概要:1、熟悉HTML语言和CSS样式表,并能够熟练使用DIV+CSS进行网页排版以及设计,擅长将网页原图

-

500元/天前端开发工程师雍唐概要:1.熟练使用 Vue 框架,搭建 Vue-cli 脚手架开发 2. 熟练掌握前端三剑客 HTM

-

500元/天前端工程师山东众阳健康集团概要:熟练运用vue全家桶; 熟练掌握Element-ui和Ant Design Vue框架; 熟练掌

-

800元/天前端开发工程师腾讯科技(深圳)有限公司概要:- 精通HTML5、CSS3和JavaScript,注重Web标准和可访问性。 - TypeScr

-

500元/天前端工程师北京蓝音科技概要:精通 html5、css3 等,可快速搭建各种布局的前端页面,并能解决兼容问题 精通 JavaS

-

500元/天BMBM概要:前端技术栈:vue全家桶、React、nodejs 微信原生小程序相关开发 鸿蒙ArkTs、Ha