有志青年'

高级爬虫工程师

- 公司信息:

- 华为ICT

- 工作经验:

- 5年

- 兼职日薪:

- 1000元/8小时

- 兼职时间:

- 可工作日远程

- 所在区域:

- 北京

- 海淀

技术能力

精通Python编程语言,熟练使用爬虫框架如Scrapy和Beautiful Soup。

深入了解HTTP协议和Web页面结构,能够解决反爬虫机制和验证码识别等问题。

熟练使用数据库管理系统,包括MySQL、MongoDB等,具备数据存储和管理能力。

具备分布式爬虫系统设计和优化经验,熟悉分布式任务调度和数据同步。

熟悉Linux操作系统和Shell脚本编写,能够进行系统级别的优化和配置。

具备团队合作和项目管理经验,能够有效协调和组织团队完成项目任务。

爬虫、数据挖掘、数据分析

项目经验

小红书、B站、抖音、知乎、微博、贴吧等

大规模数据爬取和处理系统

在这个项目中,我设计并实现了基于Scrapy框架的分布式爬虫系统,用于从互联网上抓取大规模数据。我使用了MongoDB进行数据存储和管理,并设计了有效的数据清洗和去重策略,以确保数据质量。通过优化爬虫系统的性能和稳定性,我成功提高了爬取效率和数据处理速度,为项目的成功完成做出了贡献。

反爬虫策略解决方案

在这个项目中,我面对网站的反爬虫策略和限制,通过分析和调研,提出了有效的解决方案。我使用了多种技术手段,包括IP代理池、请求头随机化、验证码识别等,成功规避了网站的反爬虫机制,保证了爬取任务的稳定和持续性。这个项目展示了我的技术洞察力和解决问题的能力。

网络数据分析和可视化平台

我参与了一个网络数据分析和可视化平台的开发工作,在这个项目中,我负责爬取和清洗大量的网络数据,并将其存储到数据库中。我使用了Python和Scrapy框架进行爬虫开发,结合MongoDB进行数据存储,最终实现了数据的可视化展示和分析功能。这个项目展示了我在数据处理和可视化方面的技术能力和创造力。

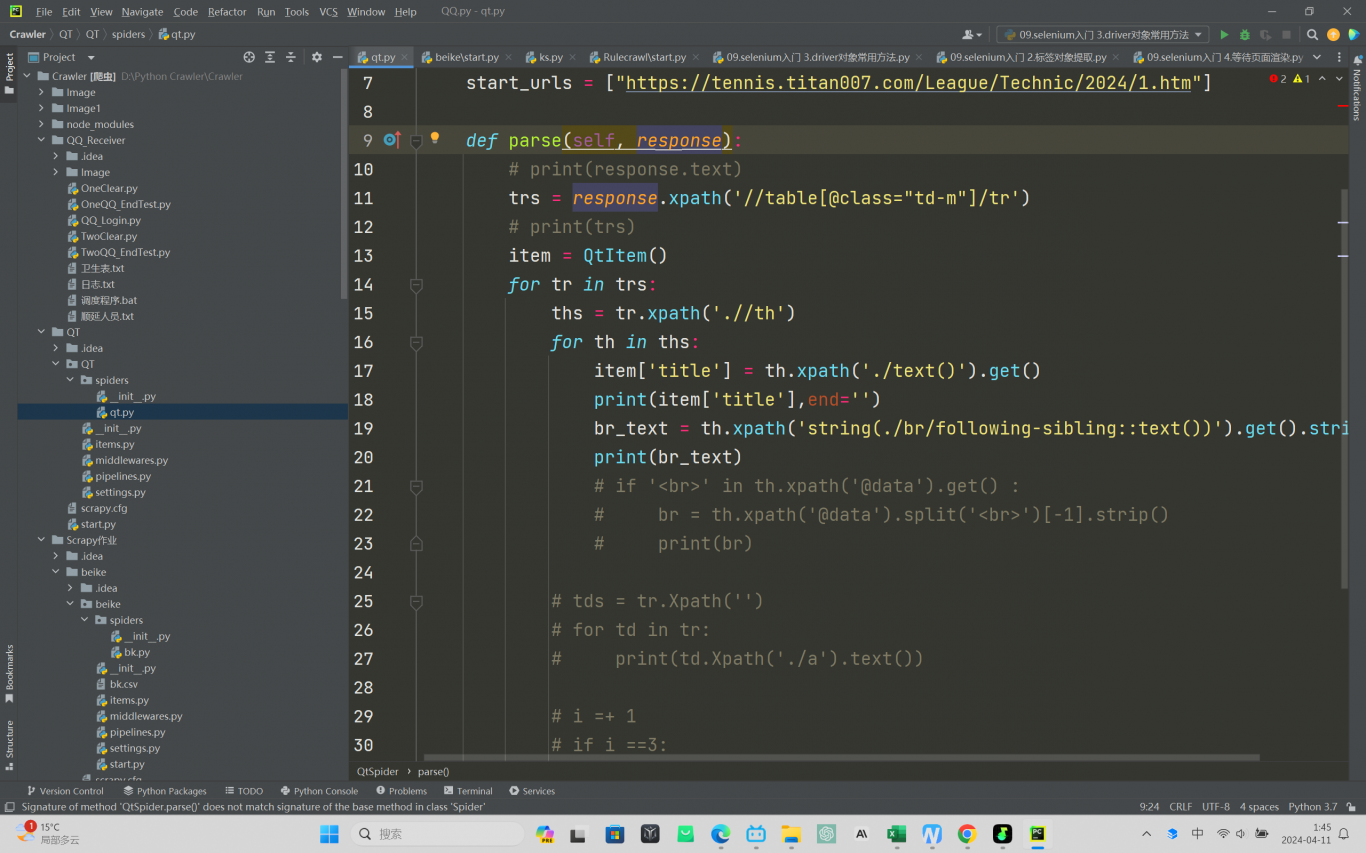

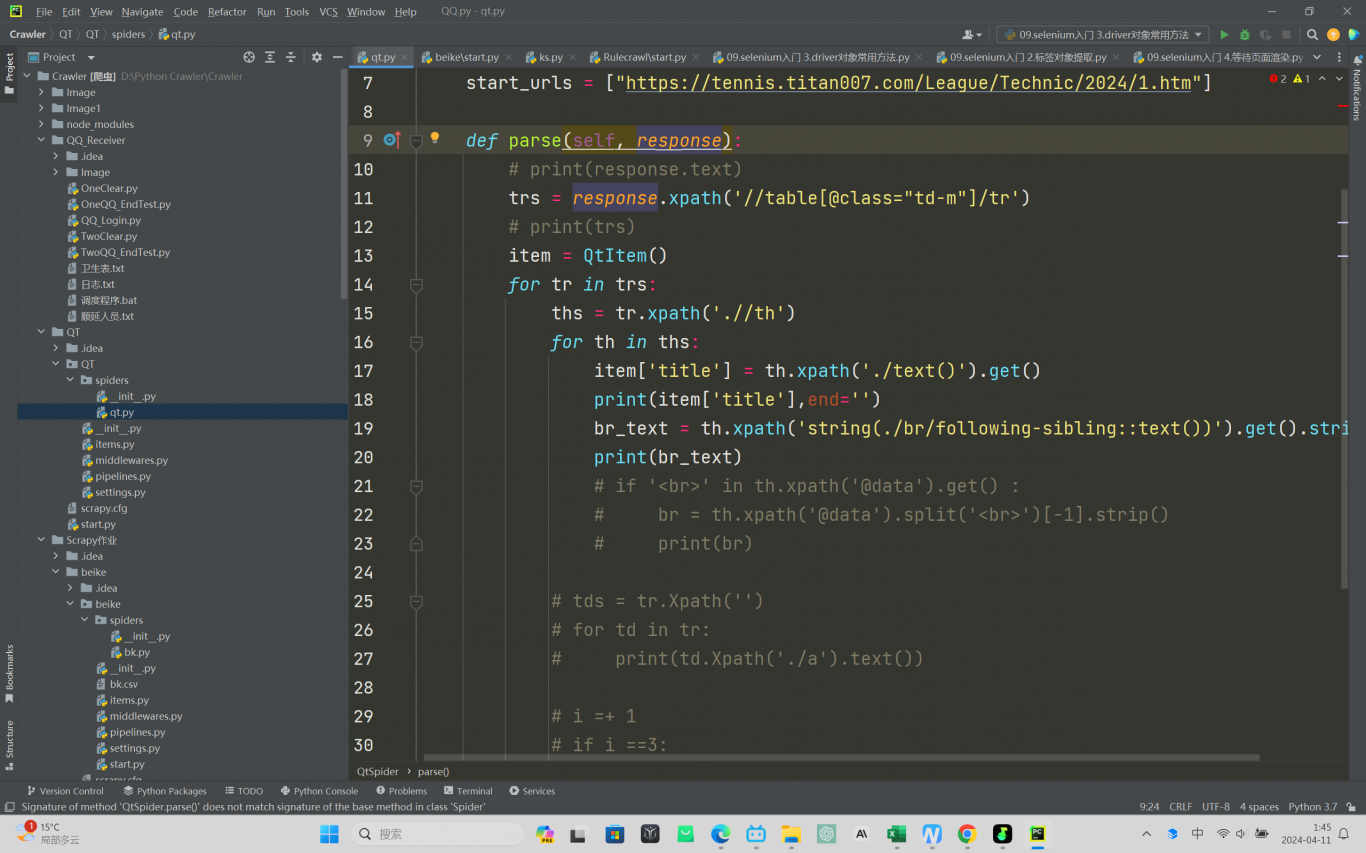

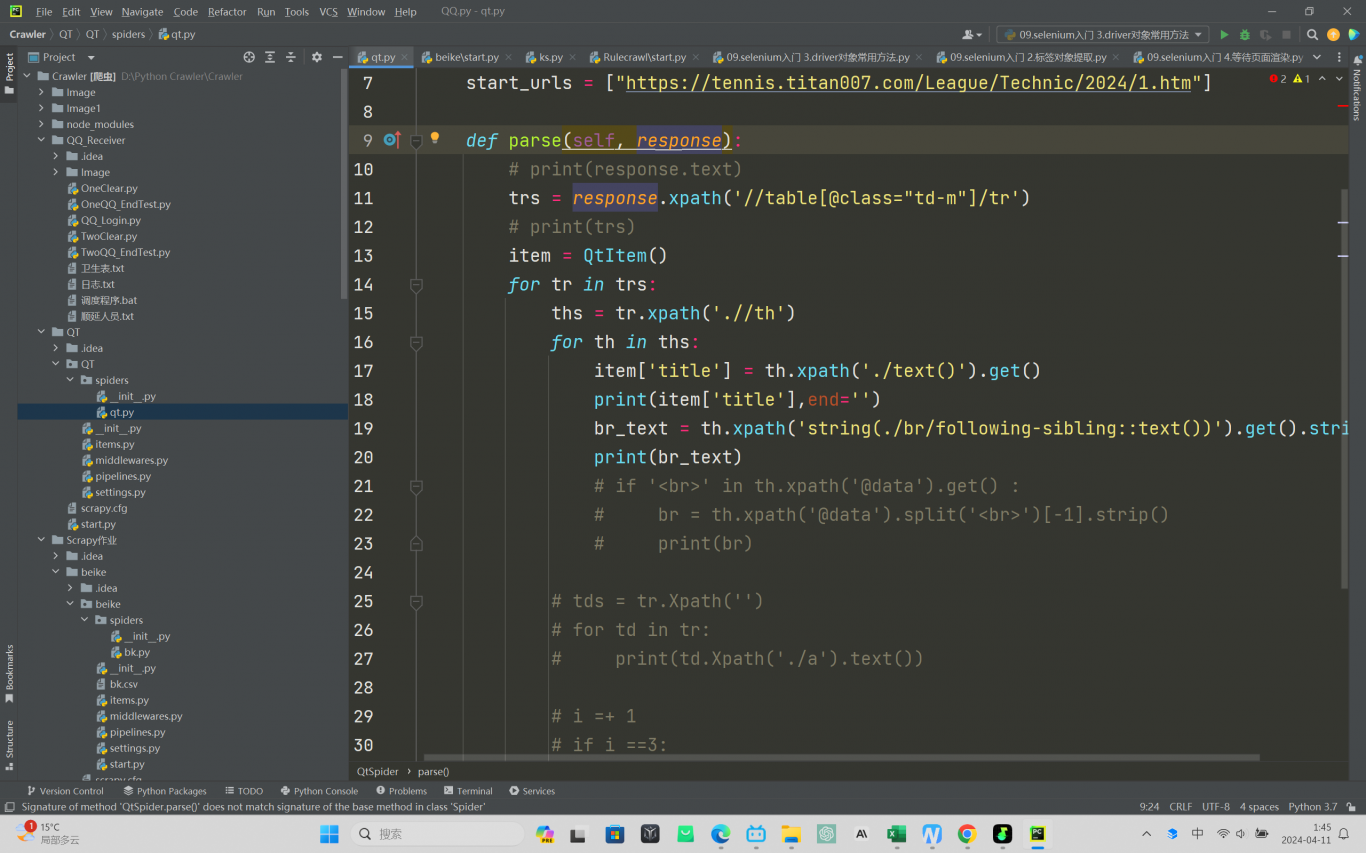

案例展示

-

小红书爬虫

分布式爬虫系统: 使用Scrapy框架构建分布式爬虫系统,能够同时处理多个爬取任务,提高了爬取效率。 数据清洗和去重: 设计了有效的数据清洗和去重策略,保证了数据的质量和准确性。 数据存储和管理: 使用MongoDB进行数据存储和管理,支持数据的快速查询和检索。 反爬虫策略

-

B站爬虫

分布式爬虫系统: 使用Scrapy框架构建分布式爬虫系统,能够同时处理多个爬取任务,提高了爬取效率。 数据清洗和去重: 设计了有效的数据清洗和去重策略,保证了数据的质量和准确性。 数据存储和管理: 使用MongoDB进行数据存储和管理,支持数据的快速查询和检索。 反爬虫策略

-

爬虫

分布式爬虫系统: 使用Scrapy框架构建分布式爬虫系统,能够同时处理多个爬取任务,提高了爬取效率。 数据清洗和去重: 设计了有效的数据清洗和去重策略,保证了数据的质量和准确性。 数据存储和管理: 使用MongoDB进行数据存储和管理,支持数据的快速查询和检索。 反爬虫策略

相似人才推荐

-

500元/天研究生中南大学概要:本人现在是研究生,专业是应用统计学,修习课程包括随机过程、统计计算、时间序列分析等,对马尔科夫链以及

-

800元/天全栈工程师自由职业概要:工作覆盖: 前端: React ,Antd等 后端: Python,FastApi 操作系

-

500元/天中级全栈安捷概要: 具备扎实的Java基础知识和良好的编程习惯,能够高效、准确地实现功能需求。 精通开源框架如

-

500元/天物流工程南华大学概要:作为一名Java程序员,我熟练掌握Java编程语言及其核心技术,具备扎实的面向对象编程功底。我熟悉J

-

500元/天报表开发系统实施巴奴毛肚火锅有限公司概要:有5年BI相关工作经验(包含可视化报表、驾驶舱),熟悉BI实施项目流程,可熟练使用帆软FineRep

-

1000元/天高级计算机视觉工程师多益网络概要:1. 熟练掌握Python、C++等编程语言,对OpenCV、PyTorch等计算机视觉与深度学习框

-

1500元/天技术负责人南京壹加陆加柒信息技术有限公司概要:专业的服务团队,十年以上工作经验,熟悉金融,互联网,传统行业,在银行,金融证券,电网,互联网等多家企

-

500元/天学生无概要:管理科学专业,擅长使用python进行数据分析以及处理表格之类的办公自动化工作,并具备一定的操作界面

500元/天学生无概要:管理科学专业,擅长使用python进行数据分析以及处理表格之类的办公自动化工作,并具备一定的操作界面